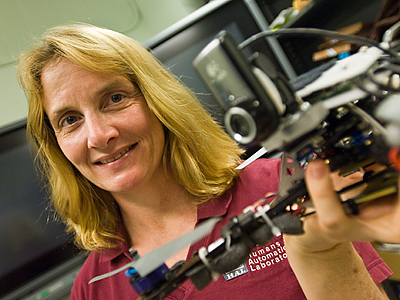

Mary Cummings是杜克大学的人类和自治实验室的主任,曾是战斗机飞行员。她对于技术伦理的探讨似乎并不是CIO们经常听到的话题,在本文里,她将以谷歌眼镜所面临的道德困境为例,讨论技术对于社会、个人隐私带来的深度影响,同时她还会解释为什么技术的社交和道德影响应该成为CIO工作事项的一部分,以及所谓价值敏感性设计的重要意义。

问:你的专业领域之一就是技术对于社交和道德的影响。CIO们是否需要意识到智能设备或人工智能对于业务的道德影响?

Cummings: 当然。每个管理层,每个人至少都需要意识到他们正在使用的技术的社交和道德的影响。

现在就有一个很好的案例分析,就是谷歌眼镜。谷歌眼镜在我使用的范围内,有着一些很强大的应用,比如,飞机的维护,汽车的维修,在你完成一项任务时,在任何你需要的时候,可以在视野内看到一组程序或其他需要的信息。 因此,谷歌使用这一技术,并开始测试,认为这会是一个非常酷的设备,是人人都会喜爱的设备。

然而,我认为谷歌是真的非常震惊,当他们发现这项技术存在那么多问题。人们不只是拒绝使用这一设备,在我去过的很多地方,门上写有标识,说明穿戴谷歌眼镜的人不允许进入,因为它侵犯了人们的隐私。

这对于谷歌而言,有点莫名其妙。但是在产品设计领域一直有相关研究,比如,价值敏感性设计,理论上,当你有一个新的产品设计时,你应该坐下来,考虑各种附属问题——你的技术可能涉及到的社会和道德问题——这样你至少可以意识到这一点。 如果谷歌在早期意识到这一点,他们就会处于更有利的位置。

问:我从来没听说过 “价值敏感性设计” 这个术语。这一流程应该从何着手呢?

Cummings: 作为一名CIO,在设计产品的早期考虑这一因素是很重要的。即使你已经有了一个设计完成的产品,你也要尽快开始这一流程。你最好在早期解决这些问题,而不是等到有诉讼或负面新闻发生。

问:你能将道德代码编写入系统吗?这可能吗?

Cummings:有一些研究人员相信你可以对电脑进行编码,使它比人类更有道德,人类依赖于情绪反应,甚至在压力下,我们可能做出错误的决定。但是也有人反驳,认为人类的意义在于,基于人性做出决定,而不是冰冷的理性化。我的观点介于这两者之间,但是我更倾向于不编写道德代码,因为在我们进行编码的时候,我们无法预测所有的外部情况。比如,对于一台机器人杀手:我们不可能将它要面对的每一种情况,都编写进去。因此,除非你能保证结果的确定性,我不倾向于编写道德判断。

问:这是否意味着你永远不会把人类从决策系统中剔除?

Cummings: 这取决于决策系统本身。我认为在军事上是如此,因为这会涉及到生命损失,或者救治,这样的决定中需要有人类。当然,现在也有其他类型的决策——比如我的气泵的常规决策,你就不需要人类的参与。但是当我们讨论的决策会影响到一个或更多的生命时,或者,如果决策错误的话,会导致非常灾难性的结果,这样的情况就需要人类进行负责。